Introduction

Que vous soyez vidéaste amateur ou professionnel, le choix entre les normes PAL et NTSC peut sembler anecdotique… jusqu’à ce que des scintillements apparaissent ou que la fluidité de vos vidéos en prenne un coup ! Ces deux formats, utilisés dans le monde entier, sont bien plus qu’une simple question de géographie et comprendre leurs différences est essentielle.

En effet, ils influencent directement vos vidéos en jouant sur :

- La qualité

- La netteté

- Le rythme visuel

Vous découvrirez dans cet article tout ce qu’il faut savoir pour faire le bon choix entre PAL et NTSC et ainsi obtenir un rendu professionnel.

Puis nous verrons comment ce détail technique peut transformer vos vidéos, en vous assurant une image optimale pour votre audience, quel que soit l’endroit où elle se trouve.

Alors, prêt à élever vos vidéos au niveau supérieur ?

C’est parti ! 😀

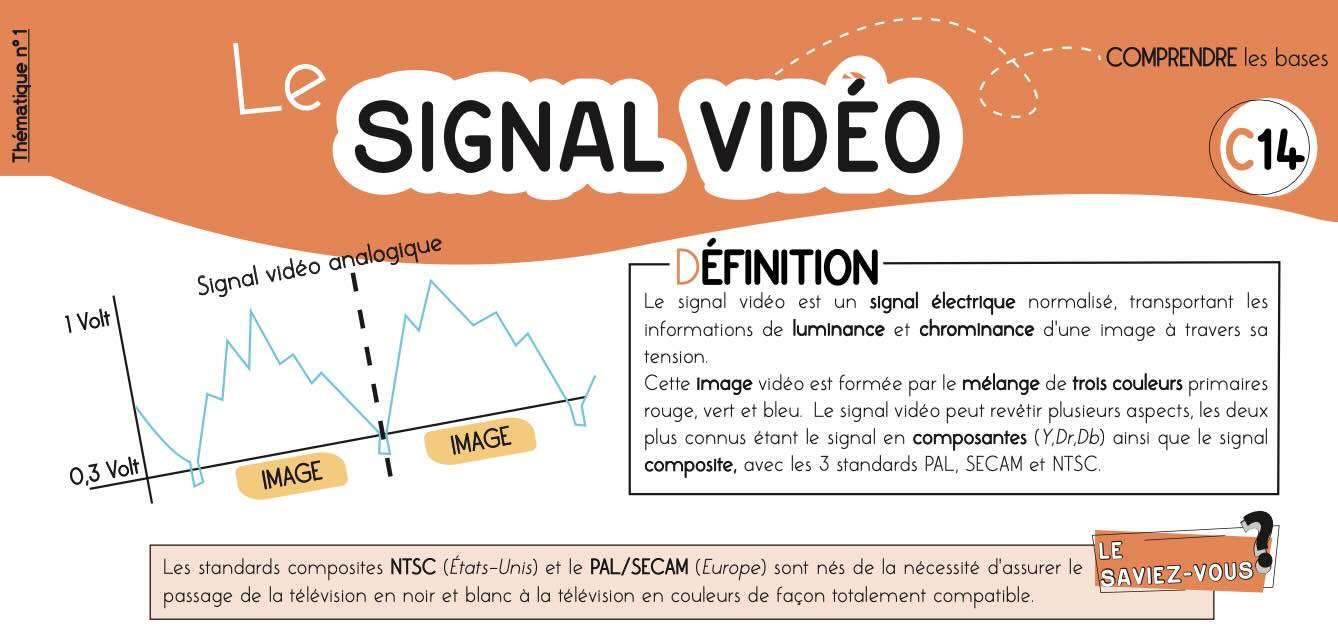

Comprendre le signal vidéo analogique

Tout d’abord, commençons par examiner le signal analogique et ses différents systèmes de codage, qui ont donné naissance à de nombreuses caractéristiques, encore utilisées aujourd’hui dans le numérique.

Une image vidéo en couleurs est formée par le mélange de trois images de couleurs primaires :

- Rouge (R)

- Vert (V)

- Bleu (B)

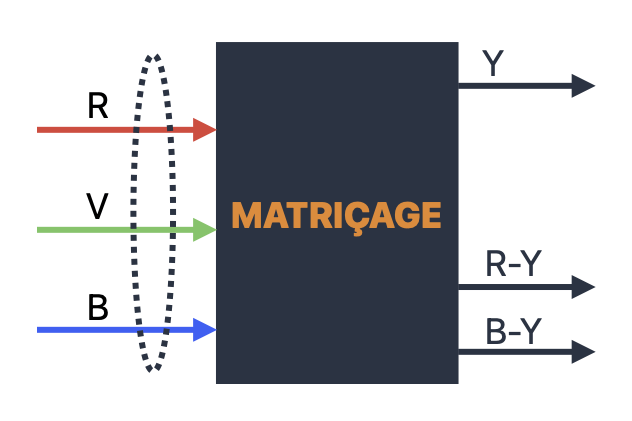

Toutefois dans la pratique, le signal vidéo ne se présente pas systématiquement sous la forme de trois signaux R, V et B correspondants à ces images primaires.

En effet, il peut se présenter sous différents aspects :

- RVB (Rouge,Vert,Bleu): Transmet les trois couleurs primaires (Rouge, Vert, Bleu) séparément, permettant un contrôle précis de chaque couleur.

- Composantes (YUV / YPbPr): Sépare le signal en luminance (Y) et chrominance (U et V ou Pb et Pr), sans inclure l’information de couleur dans la luminance.

- Composite : Regroupe toutes les informations de couleur et luminance dans un seul signal.

- Y/C (S-Video): Sépare le signal en luminance (Y) et chrominance (C), mais avec moins de précision que le signal composantes.

Avantages et Inconvénients

| Type de Signal | Qualité de l’image | Avantages | Inconvénients |

|---|---|---|---|

| RVB | Très élevée | – Meilleure fidélité des couleurs – Haute résolution d’image | – Nécessite des câbles séparés pour chaque couleur – Câblage plus complexe |

| Composantes | Élevée | – Bonne qualité d’image – Moins de câbles que RVB (généralement 3 câbles) | |

| Composite | Moyenne à basse | – Câblage simple (un seul câble) – Compatibilité large avec les équipements plus anciens | – Qualité d’image limitée – Moins bonne séparation des couleurs et moindre netteté |

| Y/C | Moyenne | – Meilleure qualité que Composite – Câblage simple (deux signaux dans un câble) | – Moins précis que les signaux RVB ou Composantes – Peu utilisé dans les équipements modernes |

Cependant, pour les besoins de cet article, nous nous attarderons uniquement sur le signal composite.

Définition du signal vidéo “composite”

Comme nous l’avons vu dans le tableau précédent, le signal composite offre l’avantage de former un canal unique où sont fusionnés les trois composantes :

- “Y” (Signal de luminance)

- “Dr” (Signal de différence de couleur R-Y)

- “Db” (Signal de différence de couleur B-Y)

La composante verte n’est pas transmise, mais elle se déduit par un matriçage simple à partir des signaux reçus.

A savoir que les informations de synchronisation, permettant la stabilité de l’image, y sont également intégrées.

En outre, il existe trois grands standards composites :

- PAL

- SECAM

- NTSC

Tous exploitent la même structure de signal vidéo.

C’est-à-dire que leurs différences portent essentiellement sur la manière dont sont combinés les signaux entre eux.

Mais ne vous inquiétez pas, nous verrons cela plus en détails un peu plus loin dans l’article.

En bref, ces trois grands standards ont vu le jour suite à la nécessité d’assurer le passage de la télévision en noir et blanc à la télévision en couleurs.

Ainsi, pour rendre ce processus totalement compatible, il était essentiel que les nouvelles émissions en couleur soient restituées correctement par les récepteurs noir et blanc dont étaient déjà équipés les foyers.

Et pour ce faire, il a fallut redoubler d’imagination … 🤔

Réduction de la bande passante de la chrominance

D’une part, la bande passante de la chrominance (couleur) a été réduite par rapport à celle de la luminance (luminosité), afin d’économiser de l’espace.

Ceci résulte d’une étude de l’américain Al Bedford en 1949, qui démontre que l’acuité visuelle de l’oeil humain est plus faible pour les détails en couleur que pour ceux en noir et blanc.

Ainsi, cette optimisation permet de transmettre un signal vidéo composite tout en respectant les limitations de la bande passante.

Cela a été réalisé au détriment d’une précision parfaite des couleurs, mais sans compromettre les détails essentiels de l’image.

Cependant, ce principe de réduction reste toujours valable aujourd’hui.

En effet, hormis les équipements très haut de gamme, il est appliqué dans tous les domaines de la vidéo numérique :

- Diffusion

- Production

- Post-production

Spectre de chrominance dans celui de luminance

D’autre part, la deuxième solution mise en oeuvre a été d’insérer dans le haut du spectre du signal de luminance celui de la chrominance.

Je m’explique …

Autrement dit, dans le signal composite, la chrominance est encodée sur une fréquence plus élevée (appelée sous-porteuse de chrominance), située en dehors des fréquences principales de la luminance.

Ainsi, cela réduit les interférences.

De ce fait, la luminance conserve ses détails essentiels, tandis que la chrominance se glisse dans le spectre en utilisant moins de bande passante.

Je vous ai perdu ??

Pour mieux comprendre, pensez à la luminance et la chrominance comme deux motifs de dentelle.

Donc, au hasard …🤭

Par conséquent, pour que les deux motifs puissent se superposer sans se gêner, la chrominance est placée précisément entre les détails fins de la luminance, utilisant les espaces disponibles dans son spectre.

Ainsi, ce procédé d’imbrication permet de « caser » la couleur dans les interstices du signal de luminosité, sans que les deux se mélangent visuellement.

Les standards vidéo PAL et NTSC

En résumé, nous avons vu qu’il existait 3 grands standards vidéo composites.

Nous allons donc à présent passer en revue les deux principaux :

- NTSC

- PAL

Inauguré en France en 1967, le SECAM a souvent laissé sa place au PAL dans un soucis de démodulation systématique des signaux en composantes Y, DR, Db.

NTSC (National Television System Committee)

Premièrement, le standard NTSC est lancé aux Etats-Unis en 1953.

Ainsi, tout comme le PAL, il transmet simultanément les deux composantes de couleurs “Dr” et “Db”.

Les signaux résultants sont mélangés pour former un signal unique de chrominance modulé en :

- Amplitude (saturation)

- Phase (teinte)

Ce dernier est alors ajouté au signal de luminance.

Sachez que le système NTSC a été l’un des premiers à introduire la couleur, mais il est connu pour être plus sensible aux variations.

Par ailleurs, cela a parfois conduit à des problèmes de synchronisation entre l’audio et la vidéo (effet de “dérapage” des couleurs) sur certains anciens équipements.

PAL (Phase Alternating Line)

Lancé au Royaume-Uni en 1967, le système PAL a été conçu pour résoudre les problèmes de couleur que le NTSC rencontrait.

En effet, le PAL utilise un système de phase alternée qui corrige automatiquement les erreurs de couleur en inversant la phase tous les deux cycles.

Ainsi, cela permet une reproduction des couleurs plus stable et précise.

Par ailleurs, ce standard est encore utilisé dans de nombreuses régions de part sa compatibilité mondiale avec quasiment tous les équipements vidéo.

Cependant, comme pour le NTSC, il est progressivement remplacé par des formats numériques à plus haute définition comme le HD et le 4K.

Différences entre PAL et NTSC en vidéo

- Le NTSC fonctionne à 29,97 images par seconde (souvent arrondi à 30 fps). Cela résulte d’un compromis pour éviter les interférences avec les signaux audio dans la bande passante de la télévision.

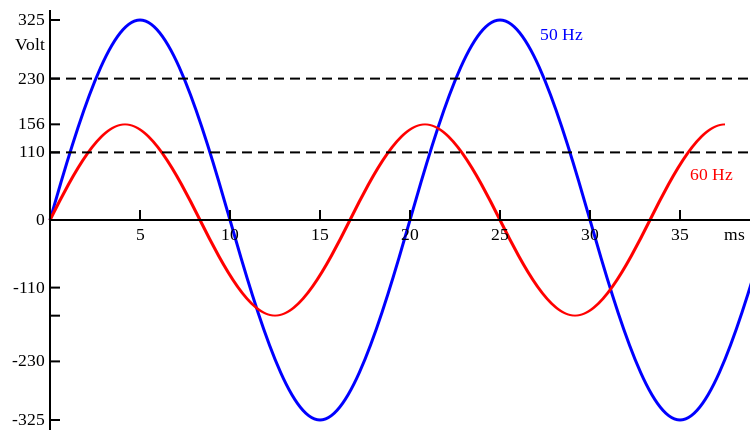

- Le PAL fonctionne à 25 images par seconde, une fréquence qui est plus proche du cycle naturel de la lumière électrique en Europe (50 Hz), ce qui permet une meilleure synchronisation avec les téléviseurs européens.

- Le NTSC opte pour une résolution de 720 x 480 pixels.

- Le PAL propose une résolution de 720 x 576 pixels.

Normes géographiques: Où utilise-t-on PAL et NTSC ?

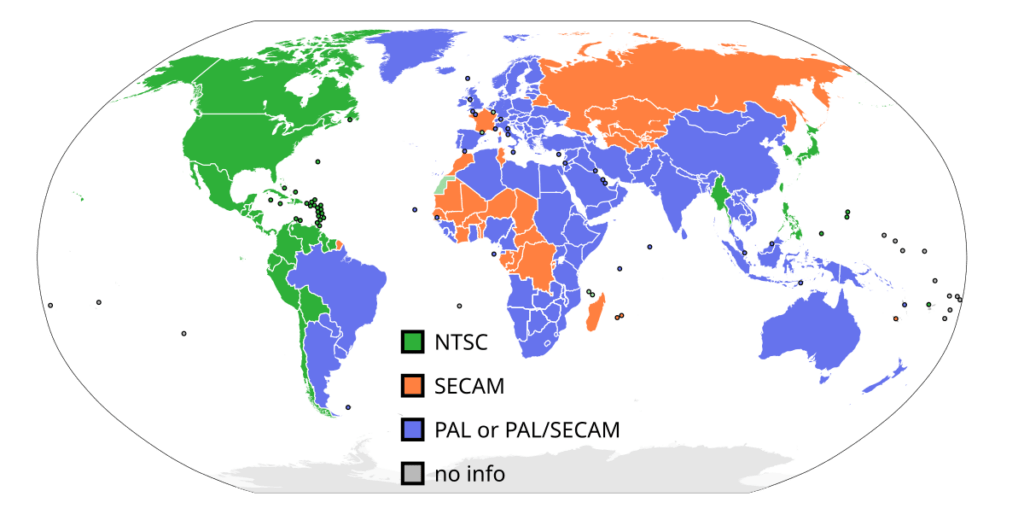

Tandis que le NTSC est principalement utilisé en Amérique du Nord, en Amérique centrale et au Japon, le PAL lui, est principalement utilisé en Europe, en Asie, en Afrique et dans d’autres parties du monde.

Le scintillement en vidéo : les solutions

En résumé, nous avons vu précédemment que le NTSC nous propose un nombre d’images par seconde plus élevé (60 contre 50 en PAL).

Cela en fait un choix idéal lorsque l’on veut tourner des ralentis en vidéo.

Pourquoi le scintillement se produit-il ?

Toutefois, il est important de rappeler que le format NTSC a été conçu principalement pour les États-Unis et le Japon, où le courant électrique oscille à une fréquence de 60 Hz.

En d’autres termes, la polarité du courant change de direction 60 fois par seconde.

Opter pour une fréquence de 60 images par seconde en tournage dans ces régions n’est donc pas un simple choix technique !

En outre, cela permet de synchroniser le rythme des images avec celui de l’électricité, assurant ainsi une stabilité optimale de l’image.

Ainsi, à 60 Hz, le système NTSC affiche 60 images par seconde, minimisant les scintillements et offrant une fluidité adaptée à l’environnement électrique local.

Explications et exemples de scintillement

Par exemple, si vous filmez à 60 images par seconde dans une région où le courant est à 50 Hz, un effet de scintillement (« flicker » ), peut apparaître.

Celui-ci est particulièrement visible sous certaines lumières, comme les ampoules fluorescentes.

Toutefois, ce phénomène peut aussi se produire en filmant des écrans dont le taux de rafraîchissement n’est pas synchronisé avec la caméra.

Dans ce cas, assurez-vous alors qu’il correspond à la fréquence du courant.

Effets du scintillement

En résumé, le scintillement peut avoir plusieurs effets :

- Fatigue oculaire

- Détérioration de l’image

- Maux de tête

Les solutions au scintillement en vidéo au tournage

Tout d’abord, la première alternative pour éviter le scintillement en vidéo, est d’aligner la fréquence d’images de sa caméra à celle du courant alternatif de l’endroit où l’on se trouve.

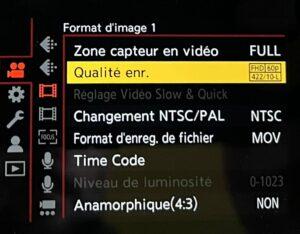

Changer la qualité d’enregistrement dans les paramètres de réglage de votre boitier :

Ensuite, la deuxième solution consiste à ajuster la vitesse d’obturation de ton boitier (”shutter speed”). Pour ce faire, essaye de régler cette vitesse à des multiples de la fréquence du courant de l’endroit où tu te trouves.

Pour une fréquence de 50 Hz (Europe) :

Pour une fréquence de 60 Hz (E-U et Japon) :

- 1/50

- 1/100

- 1/200

- 1/60

- 1/120

- 1/240

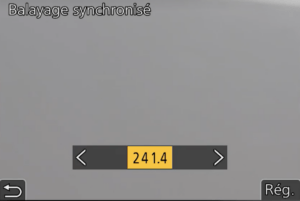

Par ailleurs, certains boitiers comme les PANASONIC ou les CANON, proposent des fonctions de “Balayage synchronisé” ou “Synchro Scan” permettant d’ajuster plus précisément la vitesse d’obturation.

N’oubliez pas d’ajuster les ISO de la caméra pour maintenir les bons paramètres d’exposition.

Pour finir, la troisième alternative est d’utiliser des lampes LED de haute qualité en remplacement des ampoules fluorescentes.

En effet, les LEDs avec alimentation en courant continu (DC) sont moins sujettes au scintillement.

Voici d’ailleurs les meilleures options disponibles sur le marché en fonction de ton budget : (liens affiliés)

Budget très élevé (+ de 1000 €)

Budget élevé (entre 500 et 1000 €)

Budget moyen (entre 250 et 500 €)

Budget limité ( – de 250 €)

Ces modèles sont largement reconnus dans l’industrie pour leur faible scintillement, même à des fréquences élevées, et sont excellents pour les tournages vidéo et les interviews.

Les solutions au scintillement en vidéo au tournage

Voici un tableau récapitulatif des 3 meilleurs plugins du marché pour enlever le scintillement en vidéo :

| Plugin | Compatibilité | Fonctionnalités | Prix |

|---|---|---|---|

| Flicker Free (Digital Anarchy) | Premiere Pro, Final Cut Pro, DaVinci Resolve, After Effects | Réduit le scintillement des LED, écrans, time-lapse | Payant |

| DE (RE Effects) | Premiere Pro, After Effects, Final Cut Pro, DaVinci Resolve | Supprime le scintillement dans les séquences slow-motion, time-lapse | Payant |

| Neat Video | Premiere Pro, After Effects, Final Cut Pro, DaVinci Resolve | Réduction de bruit et scintillement pour les vidéos bruitées | Payant |

Une autre solution consiste à utiliser l’une des fonctionnalités avancées de DaVinci Resolve : l’effet “Correction du flicker”.

Cependant, cet outil n’est accessible que dans la version payante, DaVinci Resolve Studio !

Autrement dit, une excellente raison d’envisager la mise à niveau ! 😉

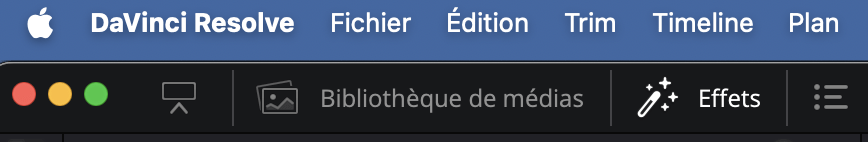

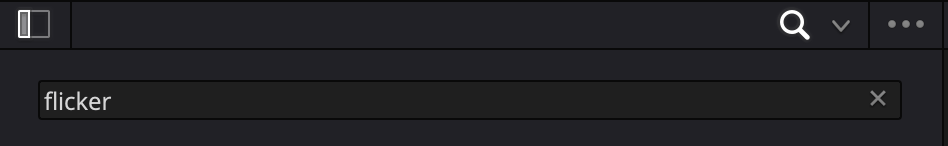

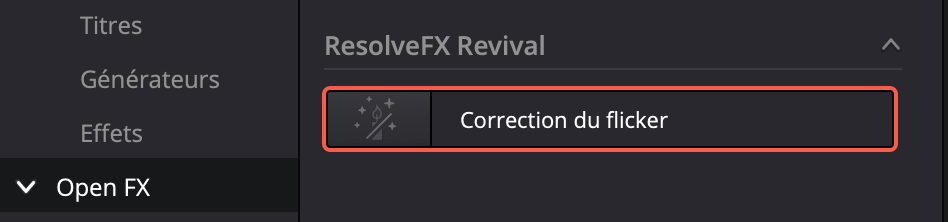

Pour utiliser cet effet, rendez-vous dans la page Montage du logiciel, puis :

-

Sélectionnez l’onglet “Effets”

-

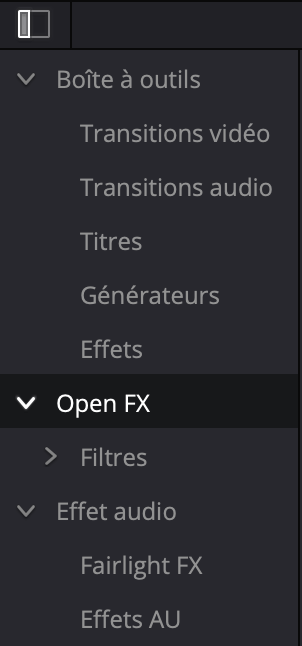

Cliquez sur “Open FX” dans le menu déroulant à gauche

-

Tapez “flicker” dans la barre de recherche en haut à droite

-

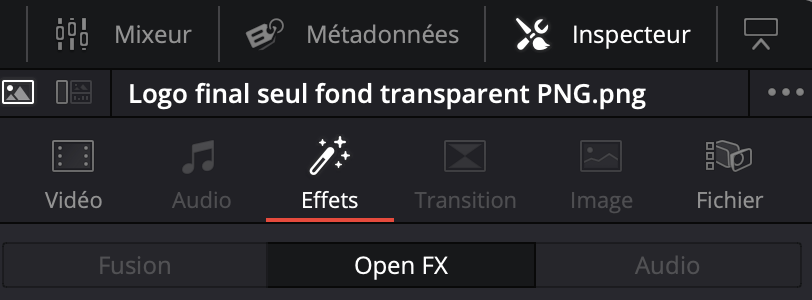

Glissez-déposez l’effet “Correction du flicker” directement sur le plan

-

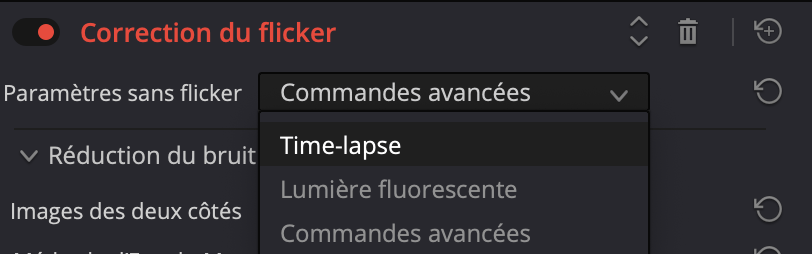

Ajustez les différents paramètres dans l’onglet “Inspecteur”

-

Réglez la correction du flicker en fonction de différents paramètres

-

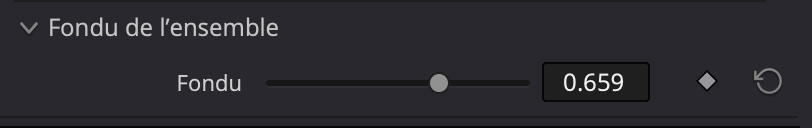

Ajustez l’effet à votre convenance en utilisant le curseur « Fondu »

Et voilà, c’est aussi simple que ça ! 😁

A savoir que cette solution a l’avantage d’être très efficace tout en vous épargnant l’installation d’un énième plugin consommateur de ressources.

CONCLUSION

En conclusion, choisir entre PAL et NTSC est crucial pour la qualité de vos vidéos.

Comprendre ces différences vous permettra d’éviter des problèmes comme le scintillement, et garantir ainsi une expérience visuelle parfaite !

Et vous, avez-vous déjà eu des problèmes avec ces formats ?

N’hésitez pas à partager vos expériences et astuces en commentaire ! ✍️

A très vite ! 😀